ICCV 2021 Oral 基于点云的类级别刚体与带关节物体位姿追踪

项目主页:

https://yijiaweng.github.io/CAPTRA/

https://arxiv.org/abs/2104.03437

引言

方法简介

基于位姿回归的方法进行端到端可微的直接预测,能够达到很高的运行速度,但容易产生更大的预测误差。我们希望结合两类方法的优势,建立一个端到端可微、精度与速度兼备的位姿追踪系统。

如下图所示,我们的模型由位姿正规化(Pose Canonicalization)、旋转回归网络(RotationNet)与坐标预测网络(CoordinateNet)组成。

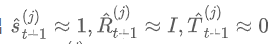

作为模型输入,令模型输出 中部件 的位姿 ,再间接计算 。

作为模型输入,令模型输出 中部件 的位姿 ,再间接计算 。 ,这意味着 中部件 总是接近正规位姿(canonical pose), 接近恒等变换,原问题的输入与输出被同时正规化,从而大大降低了网络预测位姿的难度。

,这意味着 中部件 总是接近正规位姿(canonical pose), 接近恒等变换,原问题的输入与输出被同时正规化,从而大大降低了网络预测位姿的难度。 总在恒等变换附近,直接回归就能实现准确估计。

总在恒等变换附近,直接回归就能实现准确估计。结果展示

我们的方法在类级别刚性物体位姿估计数据集 NOCS-REAL275 [1]、基于 SAPIEN [3] 的类级别带关节物体位姿估计数据集、BMVC [4] 上均超过了已有方法,以下展示部分定性结果,详细实验设定与定量结果请参见论文。

结语

[1] He Wang, Srinath Sridhar, Jingwei Huang, Julien Valentin, Shuran Song, and Leonidas J Guibas. Normalized object coordinate space for category-level 6D object pose and size estimation. CVPR 2019.

[2] Xiaolong Li, He Wang, Li Yi, Leonidas J Guibas, A Lynn Abbott, and Shuran Song. Category-level articulated object pose estimation. CVPR 2020.

[3] Fanbo Xiang, Yuzhe Qin, Kaichun Mo, Yikuan Xia, Hao Zhu, Fangchen Liu, Minghua Liu, Hanxiao Jiang, Yifu Yuan, He Wang, Li Yi, Angel X. Chang, Leonidas J. Guibas, and Hao Su. SAPIEN: A simulated part-based interactive environment. CVPR 2020.

[4] Frank Michel, Alexander Krull, Eric Brachmann, Michael Ying Yang, Stefan Gumhold, and Carsten Rother. Pose estimation of kinematic chain instances via object coordinate regression. BMVC 2015.

雷峰约稿件,未经授权禁止转载。详情见转载须知。